| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 |

- OoDD

- Federated Learning

- 개인정보

- deep learning

- DP

- FedProx

- 기계학습

- OOD

- q-FedAvg

- Machine learning

- 딥러닝

- ML

- data maximization

- Federated Transfer Learning

- Open Set Recognition

- q-FFL

- ordered dropout

- Fairness

- PPML

- FL

- Analysis

- OSR

- Agnostic FL

- convergence

- free rider

- Differential Privacy

- 연합학습

- 머신러닝

- value shaping

- FedAvg

- Today

- Total

Federated Learning

[ICML 2019] Agnostic FL - (7) 본문

논문 제목: Agnostic Federated Learning

출처: https://arxiv.org/abs/1902.00146

지난 포스트를 끝으로 알고리즘에 대한 설명을 마쳤습니다. (이전 글 보기) 이번 포스트에서는 실험 결과를 살펴보도록 하겠습니다.

10. Experiments

(1) Adult Dataset (Tabular Data)

Adult Dataset에는 총 32,561개의 data가 존재하는데, 각 data는 1명의 사람에 해당합니다. 이 dataset을 이용하여 연간 소득이 $50,000를 초과하는지에 관한 binary classification을 수행할 것인데, 이때에 박사학위 소지 여부를 기준으로 2개의 domain을 구성할 것입니다. (즉, 이는 FL에서 총 client의 수가 2인 case에 해당합니다.) 해당 dataset에는 총 413명의 박사학위 소지자가 있었고, 나머지 32,148명은 자동적으로 박사학위 미소지자로 간주합니다.

이러한 setting 하에서 logistic regression을 수행하였으며, Adagrad optimizer를 사용하였습니다. 위의 표는 각 dataset 구성 / objective function의 조합 별로 최소 50회 이상 반복하여 실험한 결과(기준: test accuracy)입니다. LˆU으로 학습된 model에 대하여 DΛ를 evaluate하였을 때 대략 69.46%의 정확도가 나왔는데, 이것이 기존의 FL에서 사용하던 방식입니다. 반면, 저자들이 제안한 LDΛ로 학습된 model에 대해서는 어떠한 domain(내지는 client)에 대해서도 최소 71.53%의 정확도를 보여주었습니다.

이는 Agnostic FL이 기존의 FL 방법들보다 더 좋은 성능을 보여준다는 것을 단적으로 알 수 있는 부분이기도 하지만, 그와 동시에 이 부분에서 Agnostic FL의 한계점도 확인해볼 수 있습니다. 이 71.53%는 곧 두 domain 중 비중이 훨씬 적은 doctorate을 prediction하였을 때의 accuracy이면서, 동시에 DΛ를 prediction하였을 때의 accuracy이기도 합니다. 이 이야기는 곧 Agnostic FL의 성능은 가장 정확도가 떨어지는 domain에서의 성능을 따라간다는 것이며, 사실 이는 Agnostic FL의 알고리즘이 max 값에 대해서만 optimization을 수행한다는 점에서부터 예견된 부분이기도 합니다.

(2) Fashion MNIST Dataset (Image Data)

다음은 우리가 잘 알고 있는 Fashion MNIST Dataset으로, 총 60,000개의 train dataset과 10,000개의 test dataset으로 구성되어 있습니다. 저자들은 그중에서 \text{shirt}, \text{pullover}, \text{T-shirt / top} label에 해당하는 data만 사용하여 각 label별로 domain을 구성하였습니다. (즉, 이는 FL에서 총 client의 수가 3인 경우에 해당합니다.)

이러한 setting 하에서 logistic regression을 수행하였으며, Adam optimizer를 사용하였습니다. 위의 표는 각 dataset 구성 / objective function의 조합 별로 최소 50회 이상 반복하여 실험한 결과(기준: test accuracy)입니다. 이 경우는 domain 별로 비슷한 개수의 data를 가지고 있기 때문에, dataset의 크기에 따른 유불리를 판별하기 어렵다는 점에서 (1)의 실험 구성과 차이를 보입니다. 그 대신, 여기에서 확인할 수 있는 것은 "비교적 판별하기 어려운 \text{shirt}"에 대한 accuracy가 상승하였다는 점입니다. 물론, 이에 대한 대가로 \text{pullover}, \text{T-shirt / top} domain의 accuracy는 일정 정도 감소하였지만, 전반적인 성능도 기존 71.2%에서 74.5%로 상승하였다는 점은 주목할 만합니다. 하지만 그럼에도 \mathcal{D}_\Lambda의 accuracy가 \text{shirt}의 accuracy를 따라간다는 점은 아쉬운 부분입니다.

(3) Penn Treebank Dataset + Cornell Movie Dataset (Text Data)

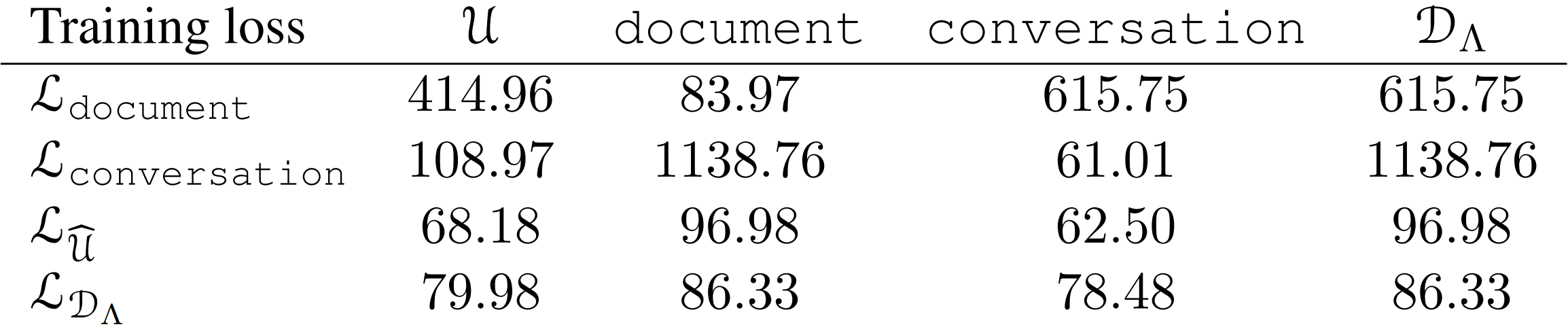

해당 실험은 기존에 존재한 두 dataset을 각각 \text{document}, \text{conversation} domain으로 구성하여 진행하였습니다. 전자는 Penn Treebank Dataset으로, 총 50,000개의 문장으로 구성되어 있으며, 각 문장 당 길이는 평균적으로 20 단어입니다. 후자는 Cornell Movie Datase으로, 총 300,000개의 문장으로 구성되어 있으며, 각 문장 당 길이는 평균적으로 8 단어입니다.

이러한 setting 하에서two-layer LSTM model을 training하였으며, Momentum optimizer를 사용하였습니다. 위의 표는 각 dataset 구성 / objective function의 조합 별로 실험한 결과(기준: test perplexity)입니다. 앞서 살펴본 다른 dataset의 경우와 마찬가지로 \text{document} domain에서의 성능을 Agnostic FL이 그대로 따라가는 모습을 확인할 수 있습니다.

11. 의의 및 한계

학습에 참여하는 client들로부터 얻은 weight를 단순히 동일하게 가중치를 주어 aggregation하는 것은 적절한 방식이 아니라는 점을 지적하고, 성능이 제일 낮은 domain(client)에 대해서 성능을 높일 수 있는 방식을 제안하였다는 점 정도가 해당 논문의 의의라고 할 수 있습니다. 다만, 한계도 명확한데, 학습에 참여하는 domain(client)의 수가 많아지면 정상적으로 학습을 수행하기 어렵다는 점은 다소 아쉽습니다. (해당 논문의 experiments에서도 최대 3개인 경우를 다루고 있습니다.) 또한, 특정 한 가지 domain(client)에 대해서만 성능 향상이 이루어지고, 이에 대한 대가로 타 domain(client)에서의 성능은 일정 정도 감소하는 것을 확인하였는데, 이 trade-off를 조금 더 줄일 수는 없을지, 그리고 더 나아가 복수의 domain(client)에 대한 성능을 높일 수는 없을지에 관해서도 고민해 볼 필요가 있습니다. 다음 review에서도 Fairness에 대한 paper를 다룰 예정인데, 해당 paper는 이 문제를 어떻게 해결하려고 시도하였는지 곧 확인해보겠습니다.

'Federated Learning > Papers' 카테고리의 다른 글

| [ICLR 2020] q-FFL, q-FedAvg - (2) (0) | 2022.11.27 |

|---|---|

| [ICLR 2020] q-FFL, q-FedAvg - (1) (0) | 2022.11.22 |

| [ICML 2019] Agnostic FL - (6) (0) | 2022.11.17 |

| [ICML 2019] Agnostic FL - (5) (0) | 2022.11.14 |

| [ICML 2019] Agnostic FL - (4) (0) | 2022.11.08 |